Die KI in ZimmWriter ist nicht mehr auf die KI API von OpenAI beschränkt. Du kannst jetzt auch die APIs der KIs von Anthropics “Claude”-Modelle sowie bestimmte Modelle von Groq und OpenRouter im ZimmWriter zum erstellen von KI-Content nutzen.

Es ist jedoch wichtig zu wissen, dass ZimmWriter ursprünglich auf den KI API Modellen von OpenAI aufgebaut war. Jedes Modell hat seine eigenen Macken und Probleme. Obwohl ich versucht habe, Dinge, die zu unerwarteten Ergebnissen führen, zu beheben, kann es sein, dass du bei der Verwendung dieser Modelle immer noch auf Fehler in den Blogbeiträgen stößt. Deshalb solltest du dir deine Artikel genau ansehen, bevor du diese veröffentlichst.

Inhaltsverzeichnis

ToggleHinzufügen von KI APIs von Drittanbietern in ZimmWriter

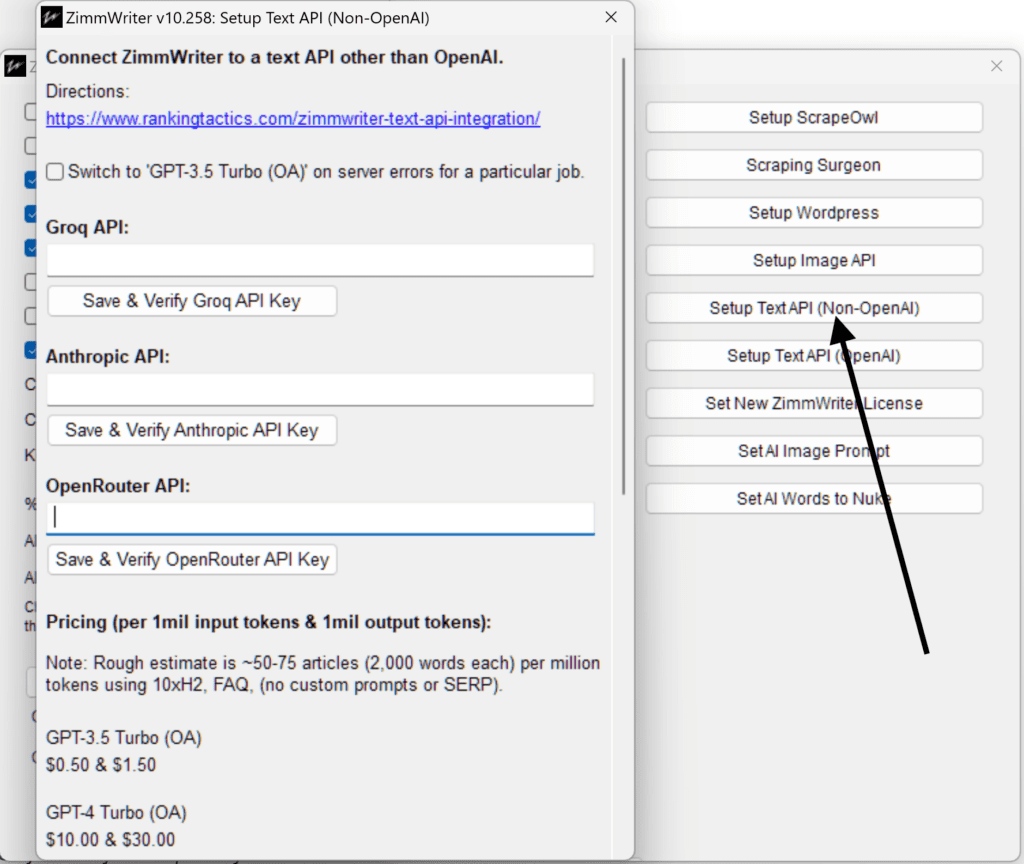

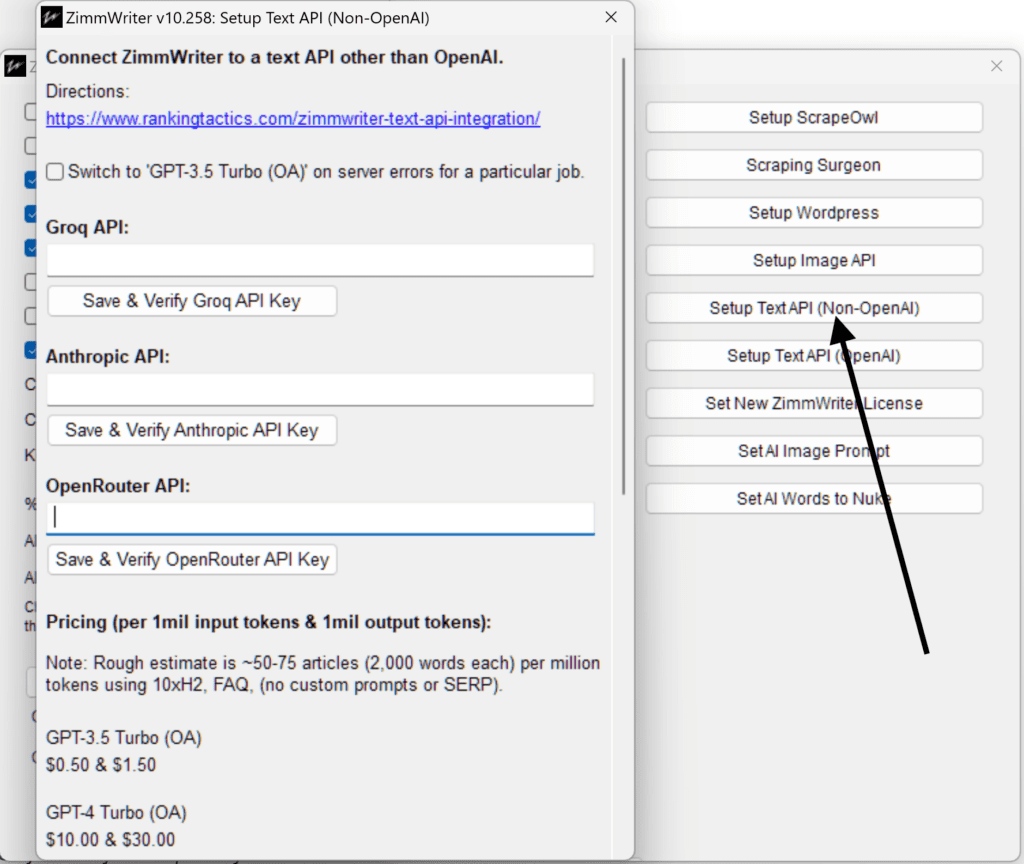

Hier ist die Stelle im ZimmWriter Optionsmenü, an der du diese zusätzlichen KI API-Schlüssel hinzufügen kannst:

Anthropic’s KI API

Anthropic ist wie OpenAI ein Unternehmen, das KI-Modelle anbietet, die ZimmWriter zum Schreiben von Blogbeiträgen nutzen kann.

So bekommst du einen Anthropic-API-Schlüssel

Gehen Sie zunächst zu Website von Anthropic und melde dich an, um einen KI API-Schlüssel zu erhalten.

Wenn du ein Konto erstellst, trittst du automatisch in den kostenlosen Bereich ein. Wie OpenAI erzwingt auch Anthropic Nutzungs- und Tarifbeschränkungen. Um schnell auf Stufe 2 aufzusteigen, die ideal für den Betrieb einer einzelnen ZimmWriter-Lizenz ist, musst du nur 50 US-Dollar auf dein Konto aufladen. Obwohl auf der Seite mit den Nutzungs- und Tarifbeschränkungen eine 7‑tägige Wartezeit angegeben ist, wurde ich sofort hochgestuft, vielleicht hast du ja auch so viel Glück.

Wenn du mehrere ZimmWriter-Lizenzen auf verschiedenen Computern verwenden musst, solltest du eine höhere Stufe in Betracht ziehen, um die Claude-Modelle von Anthropic ausgiebig nutzen zu können.

Auf der Anthropic-Website findest du auch eine Option, um einen KI API-Schlüssel zu generieren. Sobald du ihn hast, gehst du in das Optionsmenü von ZimmWriter und klickst auf “Setup Text API” (Non-OpenAI). Gib dort deinen Schlüssel ein und du bist fertig.

Anthropic’s Claude AI Modelle

Zum Zeitpunkt der Erstellung dieses Artikels bietet Anthropic drei Modelle an, die ZimmWriter derzeit nutzen kann.

- Claude 3 Opus ist das teuerste Modell und in Preis und Qualität mit dem GPT‑4 vergleichbar.

- Claude 3 Sonnet ist das Mittelklassemodell, ähnlich dem GPT‑4 Turbo.

- Claude 3 Haiku ist das günstigste Modell, vergleichbar mit dem GPT‑3.5.

Du kannst finden spezifische Preise für diese Modelle auf der Preisseite von Anthropic. Die Preise für jedes Modell sind sowohl für “Input”- als auch für “Output”-Token aufgeführt.

Was sind Input- und Output-Token?

Wenn du mit der KI interagierst, müssen wir deine Anfrage eingeben, was Input-Token verbraucht, und dann antwortet die KI, was Output-Token verbraucht.

Die Preise auf der Seite sind jedoch in Millionen von Token angegeben – zum Beispiel kostet Claude 3 Sonnet $15 pro Million Output-Token. Aber wie lässt sich das auf die Kosten für das Schreiben von Artikeln übertragen?

Es ist schwierig, das genau zu bestimmen, weil die Kosten je nach den Einstellungen, die du für das Schreiben deiner Artikel wählst, stark variieren. Eine grobe Schätzung besagt, dass eine Million Token für Input und Output zusammen etwa 50–75 Bulk-Writer-Artikel ergeben, jeder mit 10 H2-Überschriften, FAQs, ohne H3-Überschriften, ohne SERP-Scraping und ohne eigene Gliederung.

Groqs KI API

Groq ist ein weiteres Unternehmen, dessen KI-Modelle du nutzen kannst. Der Hauptunterschied ist, dass die Modelle von Groq die Open-Source-Modelle von Facebook sind. Derzeit ist das einzige Modell, das leistungsfähig genug ist, um die ZimmWriter-Aufforderungen auszuführen, das LLaMA3 70b-Modell.

Du kannst dich für ein Konto anmelden und deinen KI API-Schlüssel erhalten auf Groqs API-Seite.

Das wirklich Erstaunliche (zumindest zum Zeitpunkt des Verfassens dieses Artikels) ist, dass du die KI API von Groq jetzt schon kostenlos nutzen kannst! Bald wird sie auf einen kostenpflichtigen Modus umgestellt, aber bis dahin ist sie kostenlos.

Aber… (es gibt immer ein Aber).

Der kostenlose Plan ist in der Geschwindigkeit begrenzt, also wird er langsamer sein als die Modelle von OpenAI oder Anthropic. Aber wenn er kostenpflichtig wird, sollte er der schnellste Generator auf dem Markt sein.

Die KI-Modelle von Groq

Das einzige Modell, das ZimmWriter-Aufforderungen ausführen kann, ist LLaMA3 70b.

Die Qualität von LLaMA3 70b wird höher eingestuft als die von GPT4 Turbo, aber etwas niedriger als die von GPT4.

Jetzt fragst du dich vielleicht, warum du dieses von Facebook entwickelte Open-Source-Modell nicht einfach kostenlos auf deinem Computer ausführen kannst.

Das ist eine gute Frage.

Ich habe das Modell LLaMA3 8b getestet, das 8 Milliarden Parameter hat und technisch gesehen auf den meisten Computern laufen sollte, aber es kommt mit den Aufforderungen nicht zurecht und liefert unbrauchbare Ergebnisse. Deshalb müssen wir uns auf das Modell mit 70 Milliarden Parametern verlassen.

Das LLaMA3 70b-Modell erfordert jedoch 34 GB GPU-RAM und übersteigt damit das Maximum von 24 GB, das in Grafikkarten für Verbraucher zu finden ist. Ich bin mir nicht sicher, ob man SLI-Konfigurationen verwenden kann, aber das übersteigt wahrscheinlich die Möglichkeiten der meisten Benutzer/innen.

Der Betrieb mit PC-RAM ist aufgrund der begrenzten Speicherbandbreite ebenfalls nicht möglich.

Du könntest dir vorstellen, dass die Mac-Computer der M‑Serie mit ihrer höheren Speicherbandbreite eine Lösung sein könnten. Warum nicht mit ZimmWriter unter Parallels oder Wine?

Eine weitere gute Frage.

Leider greift auch dieser Ansatz zu kurz. Sogar mein M2 Max mit 96 GB RAM hat mit dem LLaMA3 70b-Modell zu kämpfen, was ihn unpraktisch langsam macht. Außerdem: Wie viele von euch haben Macs der M‑Serie mit mehr als 64 GB RAM?

Für den Moment bleibt Groq eine hervorragende Alternative.

Selbst wenn Groq anfängt, Gebühren zu erheben, werden die Preise mit denen von OpenAIs GPT 3.5 konkurrieren oder sogar darunter liegen.

OpenRouter’s KI API

OpenRouter ist die jüngste Erweiterung von ZimmWriter, und Junge, Junge, ist er mächtig!

Du kannst denKI API-Schlüssel von OpenRouter verwenden, um dich mit mehreren Modellen zu verbinden. Das erspart dir die Mühe, verschiedene KI API-Schlüssel zu besorgen, und hilft dir, wenn du dich in einem Land aufhältst, in dem OpenAI (oder einer der anderen KI-Modellanbieter) verboten ist.

Gehe einfach auf die Seite OpenRouter Website, erstelle ein Konto, füge ein paar Credits hinzu und erhalte einen KI API-Schlüssel.

Die KI-Modelle von OpenRouter

OpenRouter hat eine ganze Reihe von Modellen, aber ich habe für ZimmWriter nur die ausgewählt, die mit den Prompts umgehen können.

Diese Modelle können sich jederzeit ändern, da OpenRouter sie möglicherweise von seiner Plattform entfernt.

Auch die Preise sind variabel, aber sie steigen normalerweise nicht. Der Preis, der in den von ZimmWriter erstellten Textdateien angezeigt wird, ist nur so genau wie die letzte Überprüfung auf den OpenRouter-Servern. ZimmWriter prüft den Preis, wenn du ihn zum ersten Mal startest oder deinen KI API-Schlüssel änderst, also beachte das.

Hinweis: Bei einigen Modellen, wie z. B. Perplexity Online, wird eine zusätzliche Gebühr für die Anzahl der Anfragen erhoben (z. B. $ 5 pro 1.000 Anfragen). Diese Gebühr wird von ZimmWriter nicht in der Textdatei angezeigt. Behalte dies also im Hinterkopf und überwache dein OpenRouter-Konto.

Umstellung auf GPT 3.5 bei Serverfehlern

Im Optionsmenü von ZimmWriter, in dem du die KI API-Schlüssel konfigurierst, findest du eine interessante Option mit dem Titel “Bei Serverfehlern für einen bestimmten Auftrag auf GPT 3.5 Turbo umschalten.

Was machst du, wenn du mit Claude arbeitest und dein Guthaben aufgebraucht ist oder wenn die Server von Claude mitten im Job ausfallen und voraussichtlich erst in ein paar Tagen wieder verfügbar sein werden? Vor allem, wenn du gerade dabei bist, 1.000 Blogbeiträge zu erstellen?

Standardmäßig zeigt ZimmWriter eine Pop-up-Meldung an, in der du drei Möglichkeiten hast:

- Wiederholen (ZimmWriter versucht es automatisch alle 10 Minuten, oder du kannst die Schaltfläche Wiederholen drücken, um es manuell zu wiederholen) bis zu 99 Mal.

- Wechsle für den Rest deines Auftrags (z. B. das Schreiben von 1.000 Blogbeiträgen) zu OpenAIs GPT 3.5.

- Beende ZimmWriter.

Vielleicht möchtest du aber nicht, dass ZimmWriter alle zehn Minuten einen neuen Versuch startet. Vielleicht möchtest du lieber, dass ZimmWriter sofort mit der Verwendung von GPT 3.5 Turbo beginnt und die Arbeit beendet. Wenn das der Fall ist, aktiviere einfach dieses Kästchen. Wenn es aktiviert ist, wechselt ZimmWriter für den Rest des Auftrags automatisch zu den Modellen von OpenAI, wenn Anthropic oder Groq Probleme haben.