Das LongRAG-Projekt auf GitHub bietet ein System zur Generierung von Antworten auf Long Context Questions (LCQA). Es verarbeitet große Datensätze effizient und ist mit verschiedenen Konfigurationen und Datensätzen kompatibel. ZimmWriter nutzt künstliche Intelligenz zur professionellen Textgenerierung und erkennt das Potenzial von LongRAG zur Verbesserung der Ergebnisse bei der Informationsbeschaffung und der Beantwortung von Fragen. Die Verwendung von robusten Bewertungsmetriken wie F1-Scores im Projekt unterstreicht das Engagement, Fortschritte im Bereich LCQA zu fördern.

Inhaltsverzeichnis

ToggleWichtige Merkmale des Projekts

Mehrere wichtige Merkmale machen das LongRAG-Projekt zu einer innovativen Lösung für Long Context Question Answering (LCQA) Aufgaben.

Besonders bemerkenswert ist das dual-perspektivische, query-basierte Generierungssystem von LongRAG. Für diejenigen, die damit nicht vertraut sind: Bei LCQA-Aufgaben geht es darum, Antworten auf komplexe Fragen zu finden, die ein tiefes Verständnis langer, kontextreicher Texte erfordern. Das System von LongRAG ist darauf ausgelegt, große Datenmengen effizient zu verarbeiten und zu analysieren. In der Praxis bedeutet dies, dass das System robuste Lösungen für das Verständnis von komplexem Wissen in langen Kontexten liefern kann.

Ein wichtiger Aspekt des LongRAG-Designs ist der Fokus auf Datenskalierbarkeit und Retrieval-Effizienz. Diese Eigenschaften ermöglichen es dem Projekt, große Datenmengen effizient zu verarbeiten, was zu einer verbesserten Leistung führt. Datenskalierbarkeit bezieht sich auf die Fähigkeit eines Systems, mit wachsenden Datenmengen umzugehen, während Abrufeffizienz sich auf die Fähigkeit des Systems bezieht, relevante Informationen schnell und genau abzurufen.

Die Kompatibilität von LongRAG mit verschiedenen Systemkonfigurationen und die Unterstützung mehrerer Datensätze mit langem Kontext machen LongRAG zu einer vielseitigen Lösung. Dies bedeutet, dass LongRAG für eine Vielzahl von Anwendungen eingesetzt werden kann, von der Beantwortung komplexer Fragen in akademischen Texten bis hin zur Bereitstellung von Kundensupport in großen Unternehmen. Insgesamt machen das kreative Design und die beeindruckenden Fähigkeiten von LongRAG das Programm zu einem leistungsstarken Werkzeug für die Bewältigung der Herausforderungen von LCQA-Aufgaben.

Implementierungsschritte

Um das LongRAG-Projekt für Ihre Aufgaben zur Beantwortung langer Kontexte zu implementieren, bereiten Sie zunächst die benötigten Daten vor. Dieser Prozess beginnt mit dem Herunterladen von standardisierten Rohdatensätzen von HotpotQA, WikiMultihopQA, MuSiQue und Qasper. Verwenden Sie dazu den Befehl „bash download/raw_data.sh”. Dadurch wird sichergestellt, dass Ihre Daten in einem für das LongRAG-Paradigma optimalen Format vorliegen.

Sobald Ihre Daten aufbereitet sind, besteht der nächste Schritt darin, das LLaMA-Factory-Modell in das Projekt zu integrieren. Dazu müssen Sie die konstruierten Anweisungsdaten herunterladen und im Verzeichnis „LLaMA-Factory/data” ablegen. LLaMA-Factory ist ein großes Sprachmodell, das für verschiedene Aufgaben der natürlichen Sprachverarbeitung entwickelt wurde.

Wenn Ihre Daten und Ihr Modell vorhanden sind, können Sie das Training starten, indem Sie das Skript „bash sft.sh $model_name_or_path $template $cutoff_len” ausführen. Mit diesem Skript wird das Modell auf Robustheit eingestellt. Die Variable „$model_name_or_path” bezieht sich auf den Pfad, in dem Ihr Modell gespeichert ist, oder auf den Namen des vortrainierten Modells, das Sie verwenden möchten. Die Variable „$template” gibt das für das Training verwendete Modell an und „$cutoff_len” legt die maximale Länge der Eingabesequenz fest. Die Feinabstimmung des Modells ist entscheidend, um optimale Ergebnisse bei der Beantwortung von Fragen mit langen Kontexten zu erzielen.

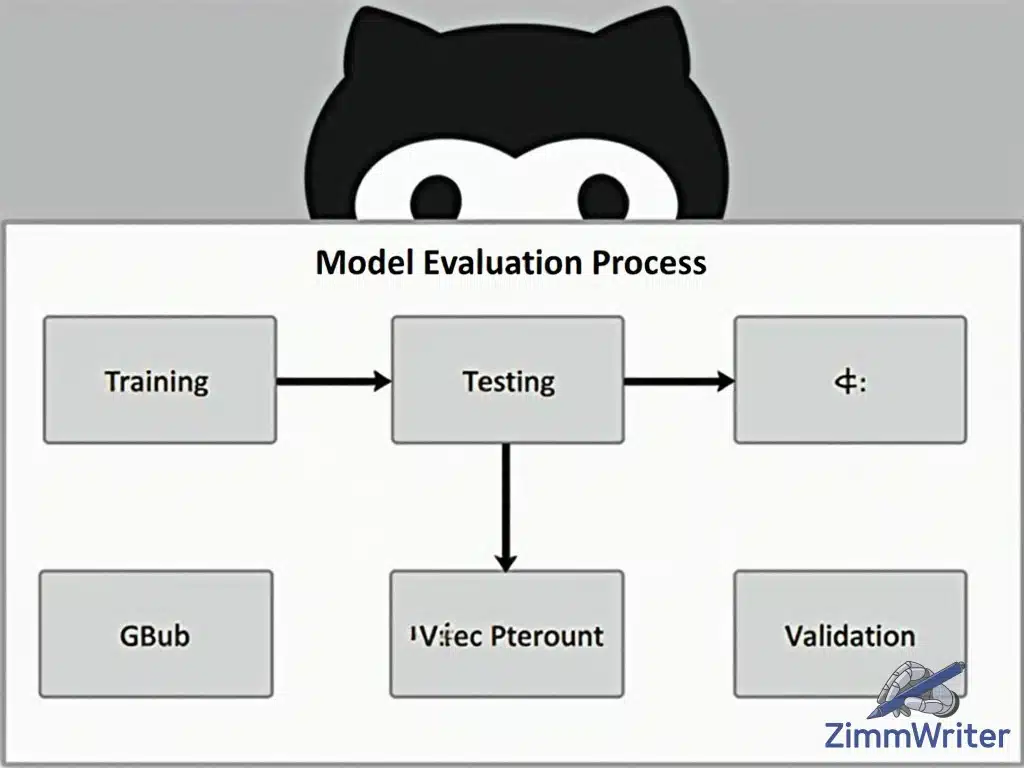

Modell-Evaluierungsprozess

Die Bewertung der Leistung von Modellen wie LongRAG, die zur Beantwortung von Fragen mit langem Kontext entwickelt wurden, ist von entscheidender Bedeutung. Um ihre Leistung genau zu messen, ist ein gründlicher Evaluierungsprozess erforderlich.

Eine effektive Möglichkeit, die Leistung eines Modells zu bewerten, ist die Verwendung von Bewertungsmetriken wie F1-Scores. Diese Metriken liefern ein quantitatives Maß dafür, wie gut das Modell funktioniert. Das LongRAG-Projekt verwendet F1-Scores, um den Nutzern ein klares Verständnis der Stärken und Schwächen des Modells zu vermitteln.

Durch den Vergleich der Leistung verschiedener Modellkonfigurationen können Entwickler die idealen Einstellungen für bestimmte Aufgaben ermitteln. Dieser Vergleich hilft, das Modell zu verfeinern und effektiver zu machen. Durch die Verwendung dieser Evaluierungswerkzeuge können die Benutzer fundierte Entscheidungen über die Bereitstellung und Verfeinerung des Modells treffen.

Darüber hinaus ermöglicht der Zugang zu Evaluierungswerkzeugen und ‑ergebnissen den Nutzern, Innovationen voranzutreiben und den Stand der Technik bei der Beantwortung von Fragen mit langem Kontext zu verbessern. Um den größtmöglichen Nutzen aus Modellen wie LongRAG zu ziehen, ist eine effektive Evaluierung und ein Benchmarking von entscheidender Bedeutung.

Der Evaluierungsprozess spielt eine entscheidende Rolle für das Verständnis des vollen Potenzials von Modellen wie LongRAG. Durch den Einsatz von Evaluierungswerkzeugen können Anwender die Möglichkeiten des Modells nutzen und bessere Ergebnisse bei der Beantwortung von Fragen mit langem Kontext erzielen.