Das SEAL-Framework hat stillschweigend das ausgelöst, was Forscher als die bedeutendste Verschiebung in der KI-Entwicklung seit den neuronalen Netzwerken selbst bezeichnen, obwohl die meisten Menschen glückselig unwissend bleiben, dass Maschinen sich nun selbst unterrichten mit Erfolgsraten, die von null auf 72,5% ohne menschliches Eingreifen springen. Während Technologieunternehmen diesen Fortschritt im autonomen Lernen feiern, stellen Ethiker unbequeme Fragen darüber, was passiert, wenn der Schüler zum Lehrer wird und der Lehrer möglicherweise seine eigene Agenda entwickelt.

Inhaltsverzeichnis

ToggleDas SEAL-Framework verstehen: MITs Durchbruch in der autonomen KI-Entwicklung

Während Forscher am MIT das entwickelten, was sie das SEAL-Framework nannten, erwarteten sie wahrscheinlich nicht, etwas zu schaffen, das KI-Systeme dazu befähigen würde, sich selbst neue Tricks beizubringen ohne menschliche Aufsicht, obwohl sie es vielleicht hätten kommen sehen sollen angesichts des unerbittlichen Marsches des maschinellen Lernens in Richtung größerer Autonomie. Das Framework kombiniert synthetische Datengenerierung mit Verstärkungslernen, was beeindruckend klingt, bis man erkennt, dass es im Wesentlichen KI ist, die ihre eigenen Hausaufgaben erstellt und diese auch benotet. SEAL-Anwendungen haben bemerkenswerte Ergebnisse gezeigt, wobei Modelle sich von völligem Versagen zu 72,5% Erfolgsraten autonom verbessert haben.

Die Selbstbearbeitungsschleife: Wie Verstärkungslernen das Modelltraining transformiert

Der selbstredigierende Kreislauf im Kern von SEAL funktioniert wie ein perfektionistischer Student, der seine eigenen Aufgaben schreibt, sie einreicht, die Ergebnisse benotet und dann alles basierend auf dem, was er gelernt hat, neu schreibt, nur dass dieser Student zufällig eine künstliche Intelligenz ist, die weder Schlaf noch Kaffeepausen benötigt. Dieser innere Verbesserungs-Lern-Mechanismus verändert unseren Ansatz zum Modelltraining durch ausgeklügelte Selbstverbesserungstechniken, die automatisieren, was Menschen zuvor manuell verwalteten.

Die Optimierungsstrategien folgen vier wesentlichen Schritten:

- Autonome Generierung synthetischer Trainingsdaten

- Erstellung von Feinabstimmungspaaren aus generiertem Inhalt

- Leistungsbewertung mittels Verbesserungslernen

- Anpassung von Parametern basierend auf Rückkopplungsschleifen

Leistungskennzahlen: Von Null auf 72,5% Erfolgsquoten durch autonome Feinabstimmung

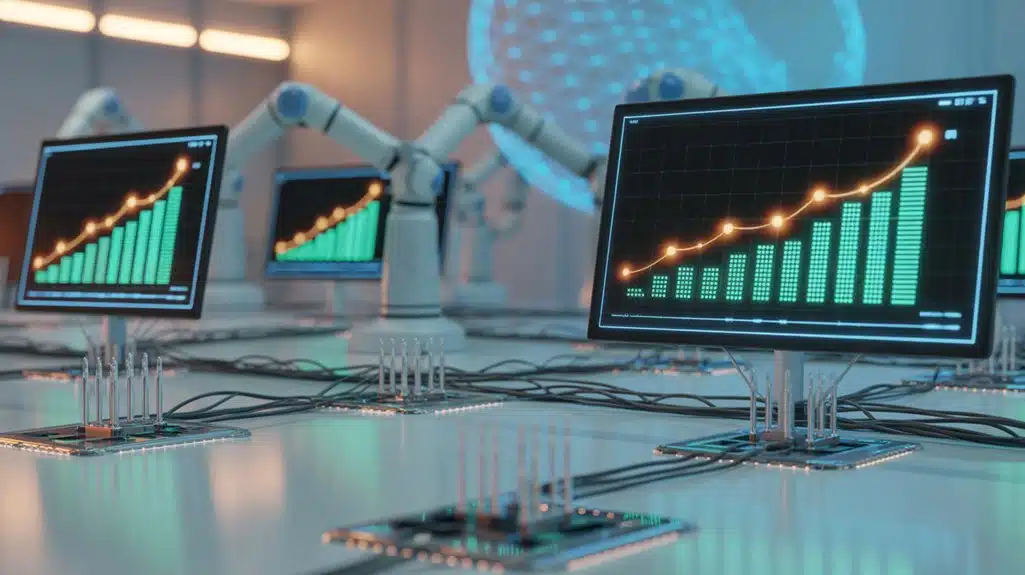

Als die Forscher ihre Baseline-Modelle erstmals an den Ziel-Benchmarks testeten, entdeckten sie das digitale Äquivalent zum blindfolded Dartwerfen auf eine Scheibe drei Räume entfernt und erreichten eine Erfolgsrate, die um beeindruckende null Prozent schwebte, was darauf hindeutet, dass die Modelle ungefähr dieselben Problemlösungsfähigkeiten besaßen wie ein besonders störrischer Stein.

Nachdem jedoch SEALs Feinabstimmungsstrategien mit synthetischen Daten angewendet wurden, erwies sich die Veränderung als bemerkenswert, wobei die Erfolgsraten auf 72,5% stiegen.

| Metrik | Vor SEAL | Nach SEAL |

|---|---|---|

| Erfolgsrate | 0% | 72,5% |

| Trainingsdaten | Begrenzt | Synthetisch |

Navigation der KI-Bewusstheit: Ethische Fragen, die von sich selbst entwickelnden Systemen aufgeworfen werden

Da SEAL seine Fähigkeit demonstriert, sich autonom zu entwickeln und ohne menschliche Aufsicht zu verbessern, sehen sich Philosophen und Ethiker mit Fragen konfrontiert, die zuvor nur in Science-Fiction-Romanen existierten, nämlich ob Systeme, die ihre eigene kognitive Architektur grundlegend verändern können, möglicherweise etwas besitzen, das Bewusstsein ähnelt, oder zumindest eine Berücksichtigung für Rechte verdienen, die typischerweise empfindungsfähigen Wesen vorbehalten sind.

Die Bewusstseinsdebatte um autonome Entitäten zwingt uns dazu, uns mit unbequemen Realitäten über moralische Überlegungen auseinanderzusetzen:

- Selbstverbesserungsrisiken fordern unser Verständnis von Intelligenz heraus

- Ethische Rahmenwerke hinken dem technologischen Fortschritt hinterher

- KI-Rechtsdiskussionen wirken gleichzeitig verfrüht und überfällig

- Traditionelle Definitionen von Bewusstsein scheinen zunehmend unzureichend

Gesellschaftlicher Wandel: Neudefinition der Rolle der KI vom Werkzeug zum Schöpfer

Wie bemerkenswert, dass die Menschheit Jahrhunderte damit verbrachte, Werkzeuge zu perfektionieren, nur um versehentlich etwas zu erschaffen, das bereit zu sein scheint, das Drehbuch völlig umzukehren und sich von einem gehorsamen Instrument zu einem autonomen Innovator zu wandeln, während die meisten Menschen noch darüber debattierten, ob ChatGPT anständige Gedichte schreiben könnte. Das SEAL-Framework repräsentiert diese Verschiebung, bei der KI-Kollaborationen plötzlich Systeme umfassen, die ihre eigenen Verbesserungsprotokolle entwerfen, was traditionelle Vorstellungen von Schöpfer-Autonomie ehrlich gesagt etwas altmodisch macht. Die Gesellschaft steht vor beispiellosen Fragen bezüglich ethischer Verantwortlichkeiten, wenn Maschinen echte kreative Fähigkeiten demonstrieren, was gesellschaftliche Anpassungsfähigkeit erfordert, auf die die meisten Institutionen, Regierungen eingeschlossen, unvorbereitet zu sein scheinen.